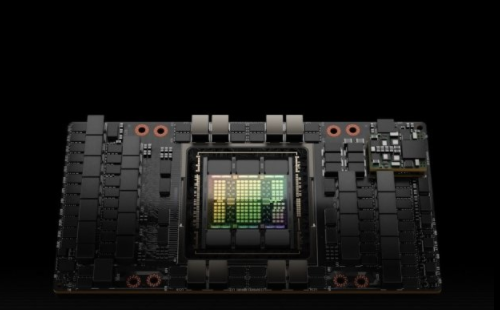

英伟达发布Hopper架构H100:800亿晶体管GPU、TDP为700W

发布时间:2022-03-23 17:29:00 阅读量:1193

在今日举行的GTC大会上,英伟达正式宣布推出采用NVIDIAHopper架构的新一代加速计算平台,同时发布其首款基于Hopper架构的GPU—NVIDIAH100。

根据英伟达介绍,H100NVIDIAGPU带来了六项突破性创新:

第一,世界最先进的芯片。英伟达表示,H100由800亿个晶体管构建而成,这些晶体管采用了专为NVIDIA加速计算需求设计的尖端的TSMC4N工艺。同时,H100是首款支持PCIe5.0的GPU,也是首款采用HBM3的GPU,可实现3TB/s的显存带宽。

第二,搭载新的Transformer引擎。H100加速器的Transformer引擎旨在不影响精度的情况下,将这些网络的速度提升至上一代的六倍。

第三,第二代安全多实例GPU。与上一代产品相比,在云环境中Hopper架构通过为每个GPU实例提供安全的多租户配置,将MIG的部分能力扩展了7倍。

第四,机密计算。H100是全球首款具有机密计算功能的加速器,可保护AI模型和正在处理的客户数据。客户还可以将机密计算应用于医疗健康和金融服务等隐私敏感型行业的联邦学习,也可以应用于共享云基础设施。

第五,第4代NVIDIANVLink。为加速大型AI模型,NVLink结合全新的外接NVLinkSwitch,可将NVLink扩展为服务器间的互联网络,最多可以连接多达256个H100GPU,相较于上一代采用NVIDIAHDRQuantumInfiniBand网络,带宽高出9倍。

第六,DPX指令。新的DPX指令可加速动态规划,适用于包括路径优化和基因组学在内的一系列算法,与CPU和上一代GPU相比,其速度提升分别可达40倍和7倍。

据了解,NVIDIAH100可部署于各种数据中心,包括内部私有云、云、混合云和边缘数据中心。这款产品预计于今年晚些时候全面发售,届时企业可从全球各大云服务提供商和计算机制造商处购买,或者直接从NVIDIA官方渠道购买。NVIDIA的第四代DGX系统DGXH100配备8块H100GPU,以全新的FP8精度提供32Petaflop的AI性能,并支持扩展,能够满足大型语言模型、推荐系统、医疗健康研究和气候科学的海量计算需求。

NVIDIA创始人兼CEO黄仁勋表示,“数据中心正在转变成‘AI工厂’,它们处理大量数据,以实现智能。NVIDIA H100是全球AI基础设施的引擎,让企业能够利用其实现自身AI业务的加速。”

据介绍,20个H100 GPU便可承托相当于全球互联网的流量,使其能够实时运行数据推理的大型语言模型和推出先进的推荐系统。

H100也是全球首款具有机密计算功能的加速器,可保护AI模型和正在处理的数据。据NVIDIA介绍,客户还可以将机密计算应用于医疗健康和金融服务等隐私敏感型行业的联邦学习,也可以应用于共享云基础设施。

标签: 英伟达

郑重声明:本文版权归原作者所有,转载文章仅为传播更多信息之目的,如作者信息标记有误,请第一时间联系我们修改或删除,感谢您的关注!

购物指南

购物指南 消费保障

消费保障 关于我们

关于我们